Att vibe-koda i gränslandet för sin egen domänkunskap

| ai | vibecoding | domänkunskap | Lästid: 4 minuter (3851 tecken)

Idén dök upp under frukosten. Strax efter lunch hade jag drygt 900 rader kod som hjälpte mig göra innehållsanalys av både poddar och nyhetstexter. Men hur vet jag om jag kan lita på slutsatserna?

Så sakteliga börjar det bli klart för mig att samma förhållningssätt gäller för AI-genererad kod som för allt annat språkmodeller producerar: det gäller att fundera på om det finns ett objektivt “rätt” – och om jag har förmågan att avgöra när resultatet uppfyller det kravet.

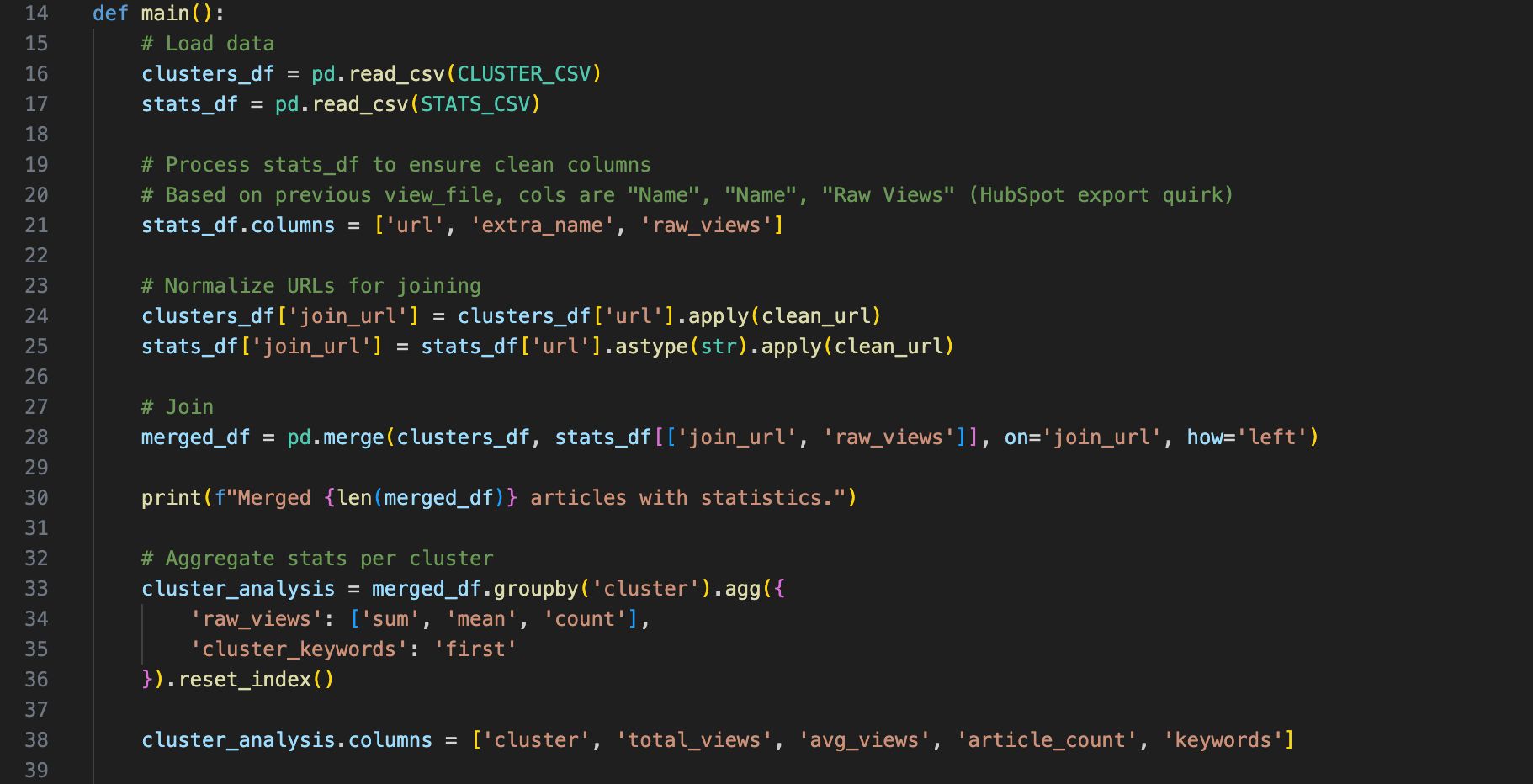

I veckan har Googles Antigravity hjälpt mig att testa en idé om innehållsanalys av de nyheter och poddavsnitt jag och mina kollegor på AI Sweden publicerar. Och som så ofta med de här utvecklarverktygen var steget från idé till första prototyp kort. Medan jag ägnade mig åt annat jobbade Antigravity på i bakgrunden under förmiddagen, med någon fråga till mig då och då. Efter lunch hade jag närmare 900 rader Python-kod som steg för steg

- laddar ner alla poddavsnitt och transkriberar dem

- laddar ner alla nyhetstexter från ai.se och rensar html-koden

- använder klustringsalgoritmer för att gruppera innehåll som handlar om ungefär samma sak

- använder siffror från HubSpot och Spotify för att lägga ett statistiklager på innehållet, för att svara på den fråga jag är nyfiken på: “Vilket innehåll får flest läsningar/lyssningar?”

Och från den här kodsekvensen blir slutresultatet en rapport med grafer, slutsatser och rekommendationer.

Efter den här övningen landar jag i två tankar:

- Återigen imponerad över vad lättillgänglig programutveckling har blivit.

- Men samtidigt en stor osäkerhet kring hur användbart slutresultatet faktiskt är för mig eftersom jag inte förstår hur det togs fram.

Jag kan verkligen inte kalla mig för programmerare, och har dessutom dålig koll på både algoritmer för klustring och på statistiska analyser. Genom att be Gemini förklara koden har jag fått viss förståelse för vad den faktiskt gör, men jag kan fortfarande inte avgöra om de valda metoderna är lämpliga för min frågeställning.

Höjer jag blicken lite så ser jag att det finns några olika typer av uppgifter och projekt som jag låter Claude Code och Antigravity hjälpa mig med:

- De där det är väldigt enkelt att avgöra om slutresultatet gör det jag vill eller inte. Hit hör exempelvis små skript för filkonverteringar och liknande, där jag med en snabb okulärbesiktning kan avgöra om koden gör det jag vill. Som hämtningen av poddar och nyhetstexter.

- De där det inte finns ett uppenbart rätt eller fel. Som verktyg för omvärldsbevakning och gallring i stora nyhetsflöden, där jag just nu testar med olika kriterier för att sortera ut den typen av innehåll som jag är intresserad av. Här är det magkänsla mer än annat som får avgöra.

- Och så slutligen de där det finns någon slags objektivt svar på om slutresultatet är rätt eller fel. Hit hör analysen av innehållet.

För några år sedan läste jag boken Calling Bullshit. Den har undertiteln The Art of Skepticism in a Data-Driven World och handlar i stora drag om hur siffror och diagram kan användas på mer eller mindre “förrädiska” sätt. Så hur kan man använda de nya möjligheterna för behov som faller inom den tredje kategorin utan att riskera att bli utsatt för statistiskt struntprat?

Domänkunskap är en rimlig del av svaret.

Ytterligare en text dök då upp i minnet, en som jag själv skrev i IVA-aktuellt 2015. På den tiden var gällande buzzword fortfarande “big data”, men det vi ser med kod-AI nu är den naturliga fortsättningen på det som den artikeln handlade om.

En av de intervjuade säger:

Man kan använda färdiga verktyg i sin forskning, men min tro är att för att kunna ta nästa steg, för att göra något som ingen annan gjort och därmed komma med de riktigt banbrytande resultaten, krävs att man också jobbar med att förbättra verktygen. De som varit mest lyckosamma inom astronomi är samma personer som utvecklat instrumenten.

Just nu diskuteras i första hand hur kodgenererande AI-agenter kommer att förändra mjukvarubranschen.

Men minst lika intressant att fundera på är hur branscher och sektorer där kod är ett verktyg och inte slutmålet i sig kommer att påverkas. Personer med domänkunskap, inklusive förståelse för sitt fälts analysmetoder, kommer rimligen kunna accelerera sitt arbete rejält.

En annan del av svaret kan kanske, åtminstone på sikt, vara en stab av AI-agenter. Anthropic har exempelvis lagt till Skills i verktygslådan för Claude Code. Med skräddarsydda prompter går det att skapa sub-agenter specialiserade på olika arbetsuppgifter. En ny punkt på min uppgiftslista är att testa en “statistik-agent” med uppgift att granska de analyser som görs. Och ytterligare en är att ta tag i den där gnagande känslan jag haft i många år om att jag behöver fräscha upp mina egna kunskaper i statistik.